Lightmatter攜創意推Passage 3D CPO 搶攻超大規模AI基礎設施

...串聯,不僅縮短模型訓練時間,也有助於提升大型模型在Token處理上的整體效率。 創意電子技術長 I...

...串聯,不僅縮短模型訓練時間,也有助於提升大型模型在Token處理上的整體效率。 創意電子技術長 I...

...程度,以在有限的資料中心空間與電力下,提升每單位的Token產出並改善生產與維修效率,但高度整合也意...

【記者呂承哲/台北報導】2026年國際消費性電子展(CES 2026)上週落幕,AI依舊是全場主軸。從AMD以Helios機櫃級平台與OpenAI、Meta站台驗證生態系,到NVIDIA以Vera Rubin全面轉向AI推論與系統級競爭,再到Intel、Qualcomm加速AI PC普及,CES 2026清楚揭示半導體產業已從單點算力競賽,進入以效率、推論與實際部署為核心的新階段。

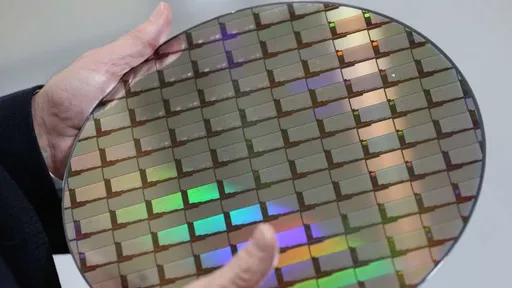

【記者呂承哲/台北報導】輝達(NVIDIA)執行長黃仁勳於CES主題演講指出,AI模型規模每年以10倍速度擴張,推理正從一次性輸出轉為「思考式推論」,加上測試階段擴展(test-time scaling)推動token生成量年增約5倍,使算力與資料中心需求同步爆炸。他直言,這已是整體運算平台的根本轉移。為此,NVIDIA宣布新一代Vera Rubin平台,並表示Rubin已進入量產,合作夥伴產品將於2026年下半年推出。

...4%。外資指出,隨大型語言模型與推理模型快速普及,Token消耗量呈指數型成長,AI晶片需求長期高於...

【記者呂承哲/台北報導】NVIDIA 宣布推出 NVIDIA Nemotron 3 系列開放模型、資料與函式庫,主打為各產業打造透明、高效率且可規模化的「代理型人工智慧(Agentic AI)」系統。Nemotron 3 提供 Nano、Super 與 Ultra 三種模型規模,並採用突破性的混合式潛在混合專家(Hybrid Latent MoE)架構,協助開發者大規模建置與部署多代理 AI 系統。

...全球資料中心主流平台,象徵 AI 正式跨入「百兆 Token 時代」。Rubin GPU 與 Ver...

... Google TPU 仍是供應鏈觀察重點,ASIC 在高 Token 使用情境下具備明顯成本優勢。

...」最高推理級別,適用科學研究、金融模型等重度場景。Token費用略高於GPT-5.1,但由於推理效率...

【記者呂承哲/台北報導】半導體測試介面領導廠商穎崴科技(6515)今(8)日公告 2025 年 11 月自結營收為 6.25 億元,月減 8.11%、年增 43.54%,創歷年同期次高;累計前 11 月營收達 69.29 億元,年增 29.69%,為同期新高。公司指出,11 月雖受產品組合影響使營收較上月略減,但在 AI 浪潮與 CSP 大型語言模型投入力道延續下,高階、高頻高速產品線持續滿載,帶動整體營運維持強勢。

...在 AI 時代,電力就是成本,多少電力能換來多少 Token 與服務量,決定 CSP 的利潤,因此 ...

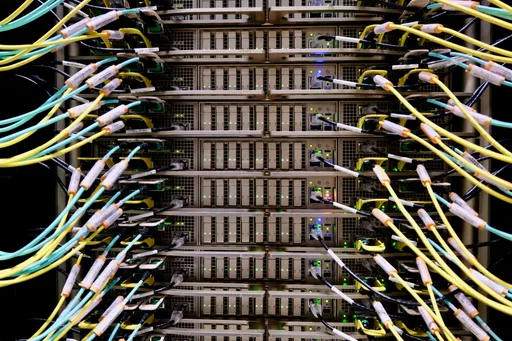

...架,共7,000顆GPU,推演能力逼近每秒200萬Token,運算規模達1GW級別。公司強調,這將不...

總部設在美國的雲端服務供應商GMI Cloud今天表示,在美國人工智慧(AI)大廠輝達支持下,該公司將在台灣建立一座價值5億美元(約新台幣155.8億元)的AI數據中心。

【記者呂承哲/台北報導】大型語言模型(LLM)與混合專家模型(MoE)持續擴張,單一 GPU 已難以支撐龐大推論需求,企業必須改採多節點架構提升速度與承載量。輝達(NVIDIA)推出 Dynamo 平台,將多節點推論能力帶入實際生產環境,讓企業能在既有雲端架構中取得基準測試等級效能,成為擴大 AI 服務的新動能。

...等CSP巨頭所推動,並打造出總持有成本(TCO)、Token成本最低的平台,帶動新一波AI革命浪潮。...

...等CSP巨頭所推動,並打造出總持有成本(TCO)、Token成本最低的平台,帶動新一波AI革命浪潮。...

...期,利用輝達GB200 NVL72平台,生產最高 Token 產生效率、最低 TCO 回應這波AI超...

【記者呂承哲/台北報導】AI 推動資料中心加速朝節能、高密度架構轉型,記憶體能效成關鍵。美光科技(Micron)宣布其 192GB SOCAMM2已正式送樣客戶,擴大低功耗 DRAM 在 AI 部署中的應用。

...模式,也凸顯輝達在AI基礎設施領域的領先優勢。 Token為大型語言模型(LLM)處理文本的最小運...

...del Hub匯聚50多種模型、累計運算量達18億Token數;開發超過35個AI助手工具、支援25...