曲建仲說明,NVIDIA的產品核心可分為GPU、CPU與DPU三大類。其中,GPU擅長處理大量、重複的平行運算,是類神經網路訓練的主力;CPU則負責作業系統與應用程式,任何具備OS與App的系統都不可或缺;DPU則專責網路、通訊與資安相關工作,是伺服器對外連線的關鍵元件。在資料中心架構上,機櫃內屬於「向上擴展」(Scale Up),機櫃之間則是「向外擴展」(Scale Out),後者高度仰賴高速交換器的支撐。

他進一步指出,目前主流交換器仍以電交換為主,即便外部傳輸使用光纖,內部交換仍需進行光電轉換,要把光轉成電,交換完再把電轉成光。在資料中心中反覆進行光電、電光轉換,導致整體能耗偏高,要一直大量的光轉電、電轉光,轉來轉去,每一個轉換都是能源浪費。

在運算架構方面,曲建仲比較GPU與TPU的差異。他指出,GPU的最大優勢在於高度可程式化,工程師可以撰寫程式,讓GPU執行各種不同任務;相較之下,TPU則屬於專用加速器,其核心為脈動陣列架構,專門用於處理張量運算,但代價是彈性較低,運算如果跟原來能夠做的差異太大,就沒法做。不過,TPU的效率顯著提升,他形容,等於是只要存取記憶體一次,就可以把六次加法做完。

他也點出TPU的市場定位。由於輝達具備完整且成熟的軟體生態系,小型客戶往往會被其平台綁定;相較之下,Google的TPU多半僅適合大型雲端服務商或超大規模資料中心使用,小客戶沒有能力自己去處理這些軟體。

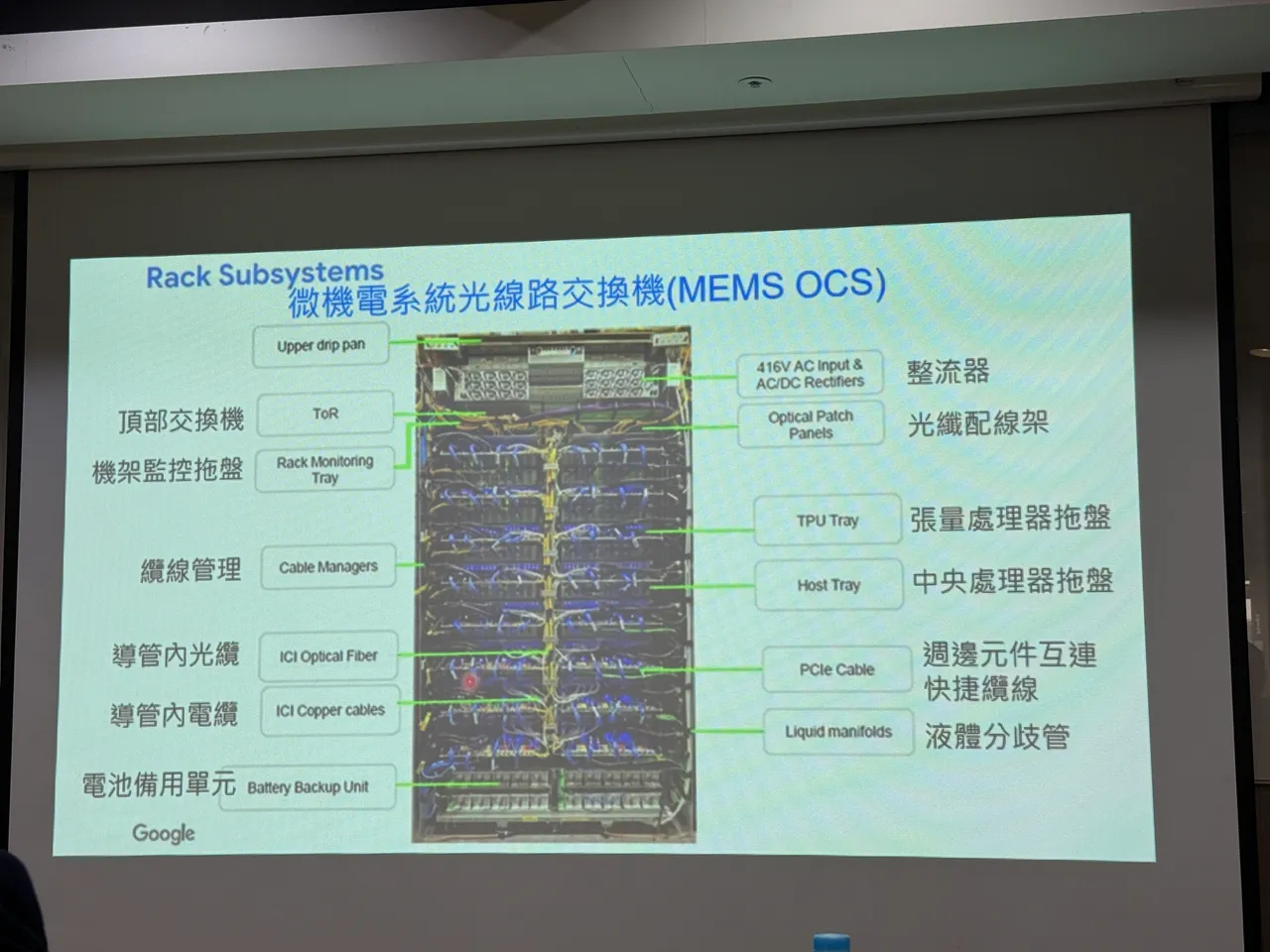

在網路端架構上,曲建仲指出,Google採取與輝達不同的作法,導入「光線路交換機」,也就是不用再轉換成電,直接用光傳輸,核心技術就是透過微機電系統(MEMS)鏡片控制光的反射方向。

他也說明,這項技術其實早在20年前就有了,但過去一直難以落地,主因在於傳統資料中心必須即時解析封包目的地,無法事先決定資料流向,直到AI訓練場景出現,在丟出去之前就已經確定它的目的地了,才能在運算開始前預先設定光路,也就是說,AI伺服器架構成為最適合的應用,這也代表這種技術並不會全面取代既有的交換架構。

曲建仲總結,無論是GPU與TPU,或電交換與光交換,未來都將依照不同應用情境各自找到最適位置,「絕對不會是誰取代誰」,AI的崛起,反而讓多年未被廣泛採用的技術,終於等到合適發揮的舞台。

點擊閱讀下一則新聞

點擊閱讀下一則新聞