GB300拉動Blackwell主要營收 網路業務成新爆發點

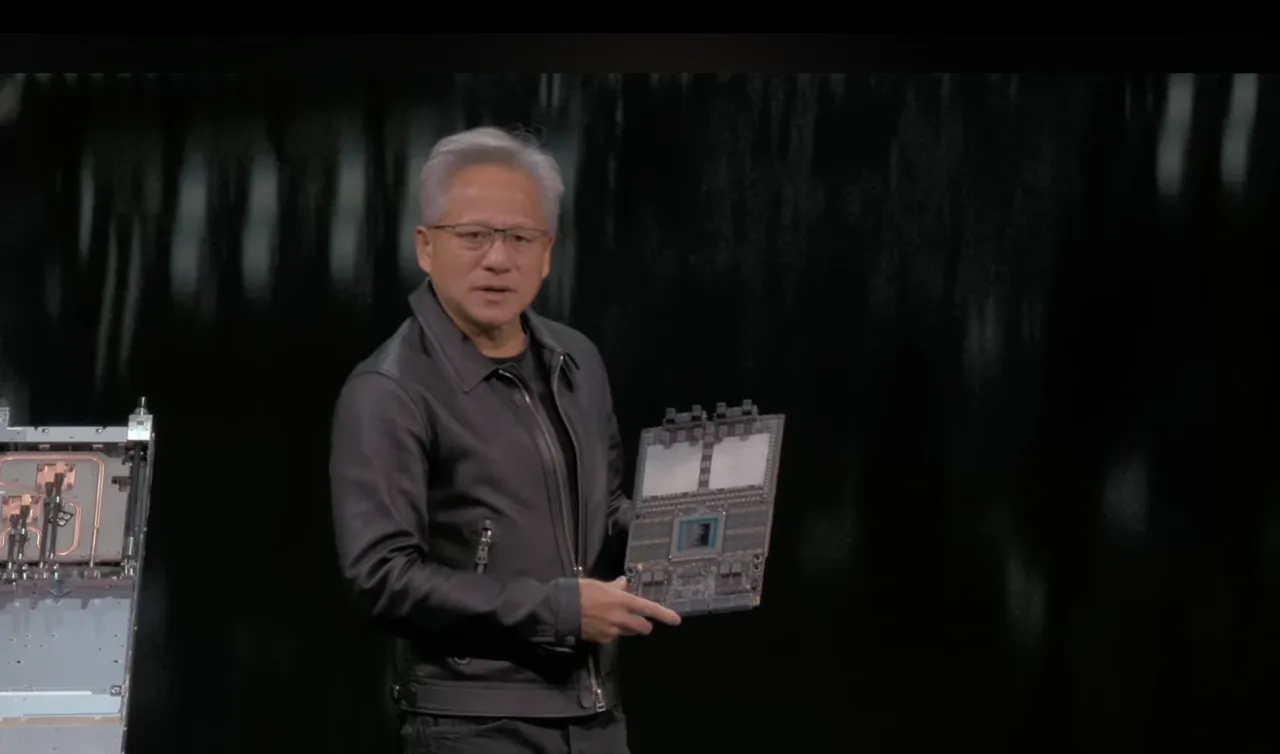

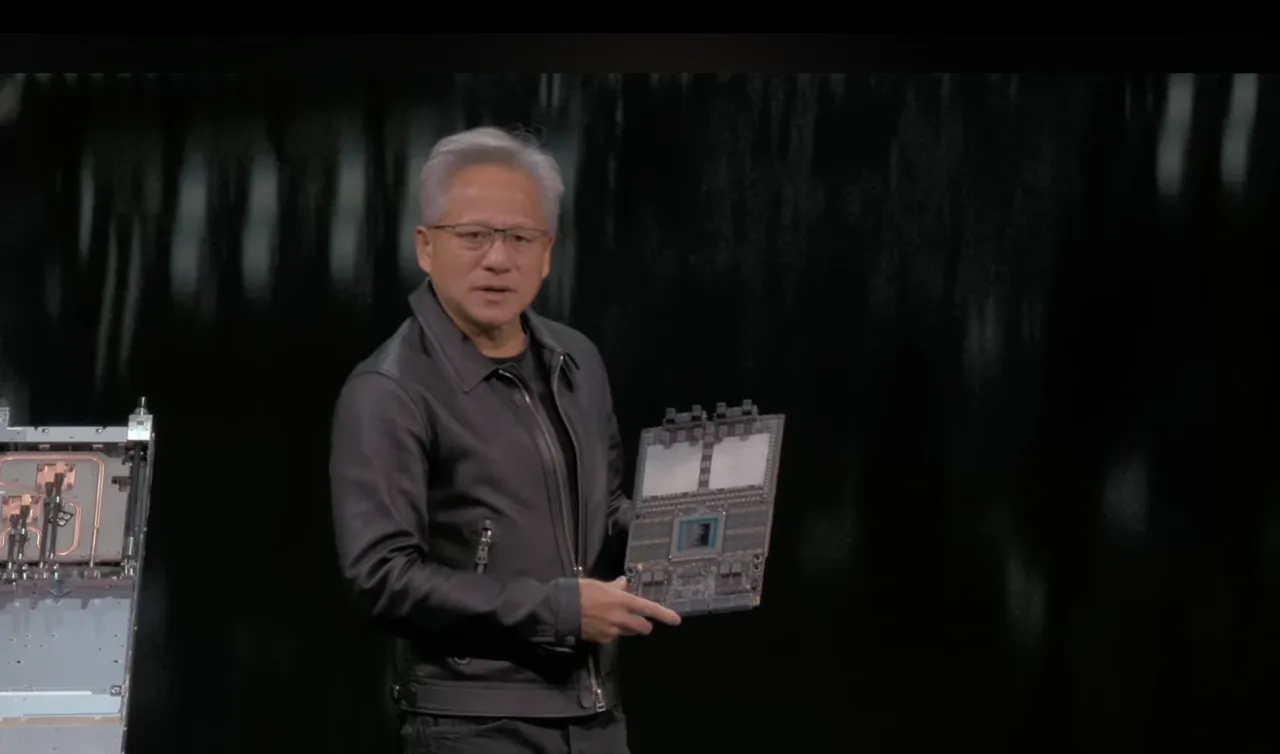

黃仁勳指出,AI 基礎建設需求持續大於供給,「雲端全面售罄」已成常態。輝達正處於加速運算、生成式 AI 與代理 AI 三大平台同步轉換,推升 Blackwell 本季正式放量,其中 GB300 伺服機櫃貢獻 Blackwell 營收的三分之二。公司也預告下一代 Rubin 將於 2026 年下半年量產,產品節奏明確,強化長期成長動能。

資料中心網路業務更成最大亮點,第 3 季營收達 82 億美元、年增 162%,輝達正式成為全球最大 AI 專用網路供應商。公司指出,AI 訓練與推理規模暴升,使高效能網路成為下一個成長引擎。

輝達說明,目前提供三種網路架構:NVLink 對應垂直擴展(scale-up)、InfiniBand 與 Spectrum-X 對應水平擴展(scale-out),而今年推出的 Spectrum-XGS 則支援跨區域擴展(scale-across),可滿足千兆瓦級 AI 工廠需求。值得注意的是,乙太網路 GPU 連接率已接近 InfiniBand,顯示開放式架構加速被採納。

黃仁勳再度澄清:ASIC難取代GPU AI演進速度才是風險

外界關注科技巨頭自研 AI ASIC 是否會威脅 GPU 在推理市場的地位。對此,黃仁勳明確表示,ASIC 僅適用於極端高量且任務固定的場景,但生成式 AI 與大型語言模型演進極快,產品還沒流片,模型就已經改版,使 ASIC 難以追上需求。

黃仁勳更是點出關鍵,其實這不是公司競爭,而是團隊競爭,因為能打造出極為複雜的 AI 晶片團隊,其實全球沒有幾個,並強調輝達的研發團隊在三大縮放定律發展(Scaling Laws):預訓練擴展(pretraining scaling)、訓練後擴展(post-training scaling)與測試階段擴展(test-time scaling),也就是AI推論(inferencing),都具有不可取代性。

黃仁勳指出,輝達的GPU 具備涵蓋訓練、推理、搜尋、壓縮、推薦等廣泛任務的通用性,加上 CUDA、生態系與 NVLink、GB 系列完整平台支撐,成為企業級 AI 的基礎架構。隨著多模型與代理AI崛起,彈性將比單一任務最佳化更重要,GPU 的通用性因此成為最大護城河。

庫存與應收帳款週轉天數增 反映提前備貨增產

財務部分則是這次市場討論最多的焦點。本季庫存季增 32%、生產與採購承諾(supply commitments)季增 63%,反映公司提前為 Blackwell 與 Rubin 準備擴產。輝達說明,庫存增加集中在原料與在製品,製成品反而季減兩成,代表是為未來放量備料,而非需求轉弱造成的成品堆積,與供應鏈為 2025、2026 年需求爆發提前備貨一致。

然而,有看空者以應收帳款週轉天數(DSO)上升作文章,指稱這是 AI 需求放緩的證據。不過,財報顯示,本季 DSO 為 53.3 天,較上季 54.1 天縮短,且輝達營收仍創歷史新高。推升 DSO 的主因是雲端客戶採購規模增加,尤其網路設備年增 162%,而企業與 CSP 在建置 AI 廠房前 4~6 個月會先購買網路設備,屬正常前置採購。換言之,DSO 增加反映高成長週期,而非需求轉弱。

AI晶片仍供不應求 黃仁勳喊想要更多產能

展望後續,輝達表示需求仍遠大於供給。法人提問中,公司指出 Blackwell 與 Rubin 在 2025~2026 年合計將貢獻約 5,000 億美元營收,隨新訂單持續加入,總量仍可能上修。黃仁勳強調,AI 訓練、推理與代理AI工作負載同時成長,必須與更多地區、更多供應商合作,提前預約未來產能,才能滿足全球對 GB300 與 Rubin 的需求。黃仁勳日前在台積電運動會也被魏哲家透露「想要更多晶片」,至於有多少,「是機密」。

點擊閱讀下一則新聞

點擊閱讀下一則新聞