此次首次登場的 NVIDIA Blackwell Ultra GPU,搭載於 GB300 NVL72 機架級系統,在 MLPerf Training 即展現驚人能量。該平台先前已於 MLPerf Inference 創下紀錄,本輪在訓練端再度刷新多項表現。

相較上一代 Hopper,Blackwell Ultra 擁有跨世代強化的架構設計,Llama 3.1 405B 預訓練效能提升超過 4 倍,Llama 2 70B LoRa 微調效能提升近 5 倍。

其中,關鍵包含全新 Tensor Core、可達 15 petaflops NVFP4 運算能力、注意力層吞吐效能翻倍與高達 279GB HBM3e 記憶體配備,使其能充分釋放 FP4 訓練模式的潛能。搭配全新 NVIDIA Quantum-X800 InfiniBand 網路平台,橫向擴展頻寬也比上一代翻倍。

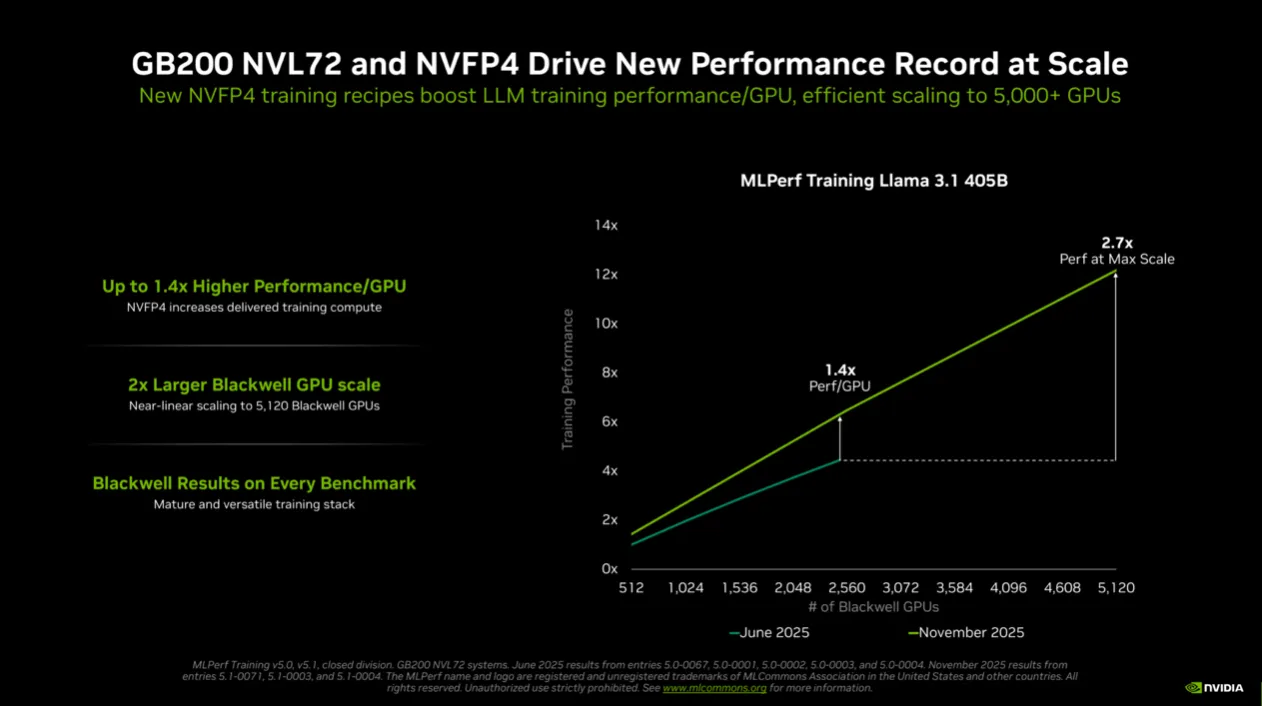

本輪 MLPerf 最大亮點,是 NVIDIA 首度以 FP4(NVFP4)精度投入訓練基準測試,並成功通過所有精度要求,樹立業界第一個以 FP4 完成基準測試的平台。

FP4 的核心價值,是以更少位元表示資料、降低運算負載,進而提升訓練速度。然而低精度訓練牽涉模型穩定性與準確度挑戰。NVIDIA 在架構、軟體堆疊與訓練流程多層創新,使 FP4 運算速度達到 FP8 的兩倍;Blackwell Ultra 更將此效能提升至三倍,為大型語言模型訓練帶來革命級加速。

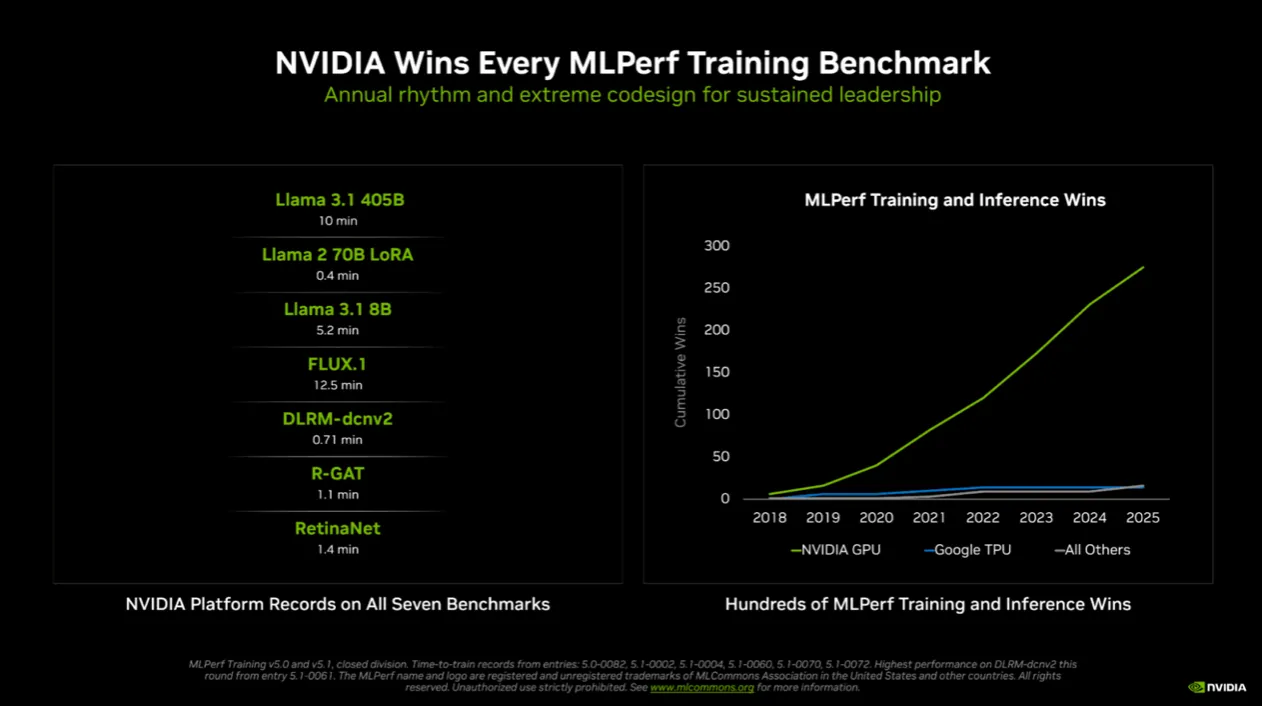

NVIDIA 在本輪測試中以超過 5,000 顆 Blackwell GPU 同步協作,在 Llama 3.1 405B 測試中創下僅需 10 分鐘訓練完成的新里程碑,較上一輪最佳成績提升達 2.7 倍。同時,NVIDIA 也展示 GPU 數量線性擴展效益:使用 2,560 顆 Blackwell GPU 時,訓練耗時縮短至 18.79 分鐘,比上一輪使用相近 GPU 數量的表現快上 45%,顯示 FP4 精度與 Blackwell GPU 架構的強力互補性。

MLPerf Training 本輪新增兩項基準測試:Llama 3.1 8B 與先進圖像生成模型 FLUX.1。NVIDIA 再次包辦最快紀錄,包括:

使用 512 顆 Blackwell Ultra GPU 完成 Llama 3.1 8B 訓練,僅 5.2 分鐘。

使用 1,152 顆 Blackwell GPU 完成 FLUX.1 訓練,僅 12.5 分鐘。

值得注意的是,FLUX.1 只有 NVIDIA 提交結果,再度說明其在生成式 AI 訓練的獨有優勢。

本輪 MLPerf 不僅由 NVIDIA 主導,更展現其龐大 AI 生態系的實力。包括 ASUS、Dell Technologies、技鋼科技(GIGABYTE)、HPE、Krai、Lambda、Lenovo、Nebius、雲達科技(QCT)、Supermicro、佛羅里達大學(University of Florida)、Verda(原 DataCrunch)、緯穎(WiWynn)等 15 家合作夥伴皆提交了多項亮眼成績,顯示 NVIDIA 平台已成全球主流 AI 訓練解決方案,各大雲端、研究機構與伺服器供應商皆在加速導入。

NVIDIA 表示,未來將以一年一更新的速度,持續提升預訓練、後訓練與推論表現,推動 AI 加速走向更智慧、更強大的下一個時代。

點擊閱讀下一則新聞

點擊閱讀下一則新聞