AI伺服器前景續旺 北美CSP、中國雙軌、本土OEM成三大動能

龔明德表示,全球AI伺服器在2023~2024年年增逾4成,從2023~2029年來看,AI伺服器出貨年複合成長率可達23%,到2029年在整體伺服器出貨占比將突破24%。同時,一般伺服器需求也逐步回升,2024年出貨年增率上修至7.6%,2025年有機會超過9%,AI帶動傳統IT投資回暖,AI伺服器也從選配,正式成為資料中心的標準基礎建設。

他說明,全球AI需求由目前三大客群驅動:北美五大CSP(Microsoft、Amazon、Google、Meta、Oracle)、中國雲端業者,以及品牌伺服器OEM。其中又以北美五大CSP最具影響力,在大型語言模型與生成式AI競賽下持續大幅提高資本支出,使AI伺服器快速成為資料中心的標配。

相較之下,中國市場在美中科技戰與出口管制下走向「國際方案+本土方案」雙軌路線。BAT等原本依賴高階GPU的企業,在H20受限後轉向自研ASIC或本土GPU,使中國AI供應生態逐漸與全球市場分化。

品牌OEM同樣受惠整體IT投資回升。龔明德指出,Dell今年出貨最為亮眼,HP則受主權雲計畫與Tier-2資料中心需求增溫而同步回溫,帶動企業級伺服器需求全面走揚。

GPU霸權持續!輝達掌握CoWoS產能 台廠三雄成大贏家

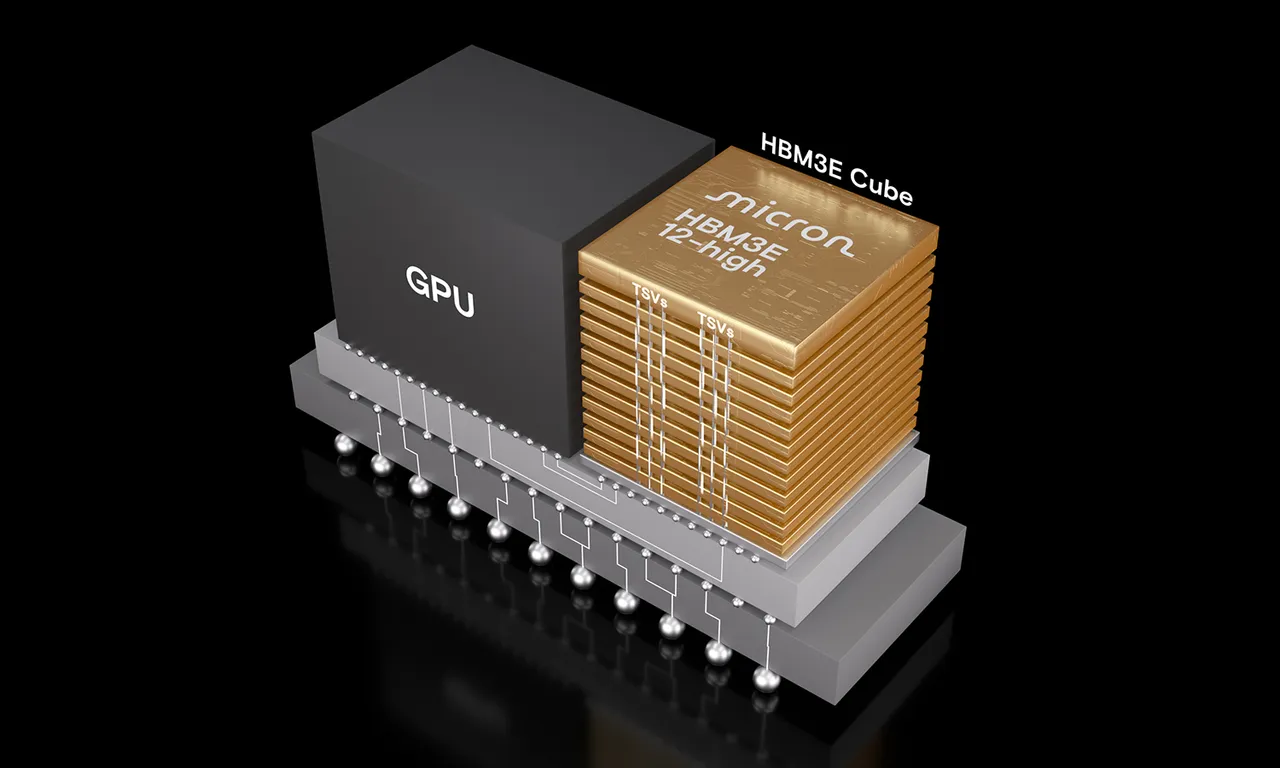

在算力供給端,GPU仍是市場主軸,自研ASIC與FPGA僅為輔助角色。其中高階GPU幾乎由NVIDIA壟斷,其H系列、B系列與GB系列產品全面仰賴台積電CoWoS與HBM堆疊技術,形成極高供應門檻。TrendForce預估,Blackwell將推升台積電CoWoS於2025年產能大增至60萬片、年增九成,2026年再增7成;2025年NVIDIA一家公司便將吃下約6成CoWoS產能,2026年即便Broadcom等ASIC放量,仍難撼動其主導地位。

在出貨層面,2024年NVIDIA高階GPU出貨約590萬顆,受H20限制略有下修,但2025年仍可達690~700萬顆。AMD MI系列將從今年60萬顆提升至明年的70萬顆以上,MI400更將以整櫃機型對決NVIDIA VR系列;Intel則在高階GPU市場動能偏弱。

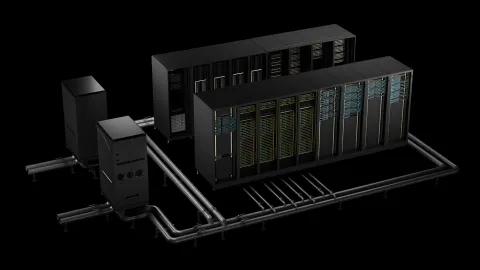

算力需求的持續拉升,也讓AI伺服器架構快速轉向整櫃部署,GB Rack成為新焦點。GB200為今年主力,GB300將於第四季開始出貨並於明年放量。TrendForce預估,2025年GB Rack出貨達3.6萬櫃,2026年將增至5.9萬櫃,成長速度遠超整體伺服器市場,其中,8成以上來自北美五大CSP,Oracle與Microsoft增速最快。

整櫃化浪潮也讓台廠成為最大受惠者。鴻海、廣達、緯創承接GB主力機櫃訂單;英業達、美超微、技嘉則聚焦H100S八卡機與部分客製化案。由於整櫃AI產品單價可上看350萬美元,台廠AI伺服器營收占比快速走高,廣達今年AI占比達7成,明年更有望突破8成。

自研ASIC崛起+中國AI晶片本土化 華為量能2026挑戰百萬顆

非GPU勢力也在快速壯大。Google TPU、AWS Trainium/Inferentia持續演進,Meta MTIA與Microsoft Maia系列加速追趕,使自研ASIC在AI運算晶片中的占比推升。TrendForce預估,自研ASIC占比2025年將升至25%,2030年前後有望逼近40%。

中國AI生態受出口管制影響劇變。H20受限後外購GPU占比明年恐降至三成,本土GPU+ASIC加上中國CSP自研晶片市佔已逾4成,未來突破5成並非難事。華為與寒武紀是最大動能,華為2025~2026年AI晶片出貨更有望挑戰百萬顆規模,成為成長最快速的AI晶片勢力。

CoWoS與HBM仍是瓶頸 地緣政治成最大變數

他提醒,無論是GPU或自研ASIC,最終都繞不開CoWoS與HBM這兩大核心瓶頸。HBM從HBM3e邁向HBM4,三星、SK海力士、美光三大記憶體原廠近年大幅集中投資,讓供需長期呈現緊俏,未來恐成推升AI伺服器成本與壓縮毛利的最關鍵變數。

龔明德總結,雖然一般伺服器需求已回升,AI伺服器仍維持逾兩成的年增率,北美CSP將是推動市場的核心力量,2028~2029年後Edge AI推論也可能帶來新一波成長動能;然而,美國大選後科技管制、出口政策與關稅走向,仍將決定2026年後全球AI伺服器與半導體供應鏈的最大不確定性。

點擊閱讀下一則新聞

點擊閱讀下一則新聞